在当前AI技术飞速发展的大环境下,大多数重要技术由顶尖公司开发,但往往闭源,这对那些喜欢自己动手的DIY爱好者来说是个挑战。然而,近日,复旦大学发布了开源的MOSS,这一动作受到了广泛关注,也使得那些热衷于自主研究的人士看到了新的希望。

![图片[1]-用V100运行MOSS,曲折一天的“DIY”尝试记录-山海云端论坛](https://www.shserve.cn/wp-content/uploads/2024/02/20240205172143739-image.png)

MOSS被宣称可以在只需30GB显存的情况下运行FB16精度,甚至在4bit量化版本下只需要12GB显存。对于那些想要尝试的人来说,这似乎是一个吸引人的优势。于是,我决定在腾讯云上配置一块32GB的V100,打算体验一番。然而,事实证明,我有些天真了。

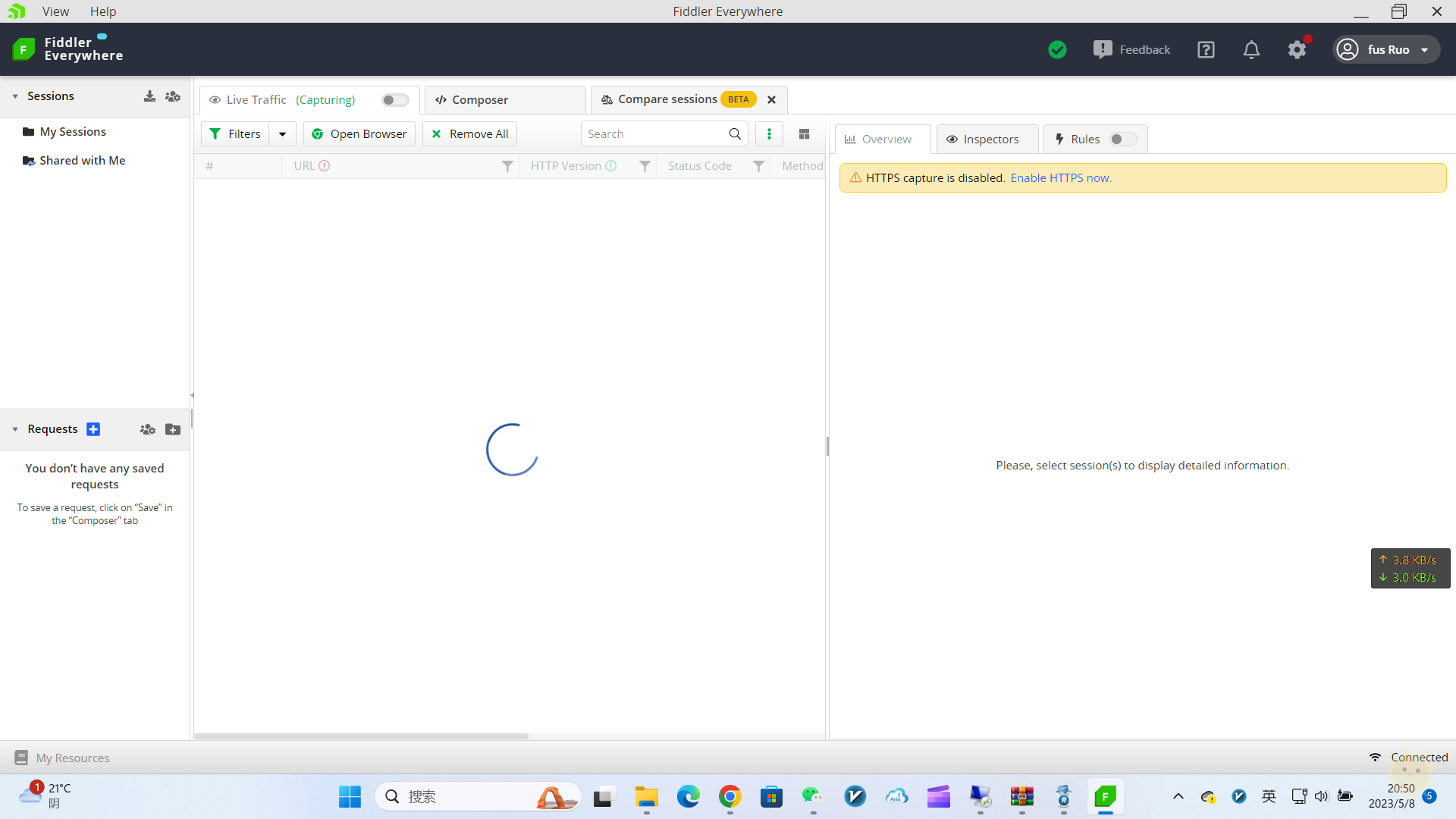

首先,我在云端GPU上安装了Windows Server 2019,但在进行git clone时,遇到了国内服务器不稳定的问题。我转而使用了gitee,并意外发现了一个1:1复刻github的镜像,这解决了我的第一个问题。

接着,我遇到了pip和conda下载缓慢的问题,不过通过各种镜像源的设置,这一问题也得以解决。

然而,最大的挑战来自于30多GB的模型文件。我在运行时才发现了这一点,这使得我不得不等待下载完成。虽然下载速度不是很快,但我还是坚持等待了下来。

![图片[2]-用V100运行MOSS,曲折一天的“DIY”尝试记录-山海云端论坛](https://www.shserve.cn/wp-content/uploads/2024/02/20240205172201355-image.png)

接下来,我遇到了Torch not compiled with CUDA enabled的问题,经过一番尝试,我通过Conda命令安装了最新版的Torch,解决了这一问题。然而,随之而来的是OutOfMemory错误,让我不禁开始怀疑是不是我的配置出了问题。

![图片[3]-用V100运行MOSS,曲折一天的“DIY”尝试记录-山海云端论坛](https://www.shserve.cn/wp-content/uploads/2024/02/20240205172215101-image.png)

在尝试使用轻量化模型时,我又遇到了新的问题。轻量化模型的量化环境无法在Windows上安装,而只有Linux版本可用。于是,我决定切换到Ubuntu系统,并通过NVIDIA官网下载了指定版本的驱动程序。

然而,即使在Ubuntu系统上,我依然无法成功运行MOSS。尽管界面出现了,但OutOfMemory错误仍然困扰着我。最终,我发现了一个MOSS项目主页的更新,原来之前所说的模型加载只需31GB的显存,并不意味着完成对话也只需要这么多。这个发现让我意识到了我的天真与无知。

最后,我尝试将模型下载到本地电脑,然后再上传到云端,但我又遇到了网络速度的问题。限制了文件大小的上传限制使得我的计划再次受挫。

总而言之,尽管我做了充分的准备,但硬件配置的不足使得我无法顺利运行MOSS。这次的尝试让我意识到了技术发展的快速变化,以及在追求新技术时所面临的挑战。或许,我该换个方式,用V100来玩个斗地主,也不失为一种不错的选择。

![表情[qiudale]-山海云端论坛](https://www.shserve.cn/wp-content/themes/Shanhai/img/smilies/qiudale.gif) 我也是买了领不了、

我也是买了领不了、

暂无评论内容